Als we praten, sturen onze hersenen ons spraakorgaan aan. Wetenschappers zijn erin geslaagd die aansturing af te lezen met hersenscans. En ze konden ze omzetten in verstaanbare woorden en zelfs zinnen.

Mensen die door ziekte of een ongeval niet meer in staat zijn om te spreken, schrijven, typen of met gebaren te communiceren, vinden soms een laatste redmiddel dankzij complexe systemen gebaseerd op oogbewegingen (knipperen bijvoorbeeld) of lichte bewegingen met het hoofd. Deze systemen zijn vooral bekend van locked-in-patiënten, maar ook van mensen met zware ALS – denk maar aan de vorig jaar overleden Stephen Hawking en zijn spraakcomputer.

Die systemen werken helaas traag (meestal genereren ze niet meer dan tien woorden per minuut), en hun output komt al helemaal niet in de buurt van spraak. Spreken doen we dan ook zeer snel, tot zo’n honderdvijftig woorden per minuut.

Daarom proberen wetenschappers al jaren via een zogeheten brein-computerinterface rechtstreeks woorden en zinnen in de hersenen af te lezen. Helaas is dat zeer moeilijk, want een hersensignaal is niet hetzelfde als een geluidssignaal dat middels een audioinstallatie verstaanbare tekst wordt.

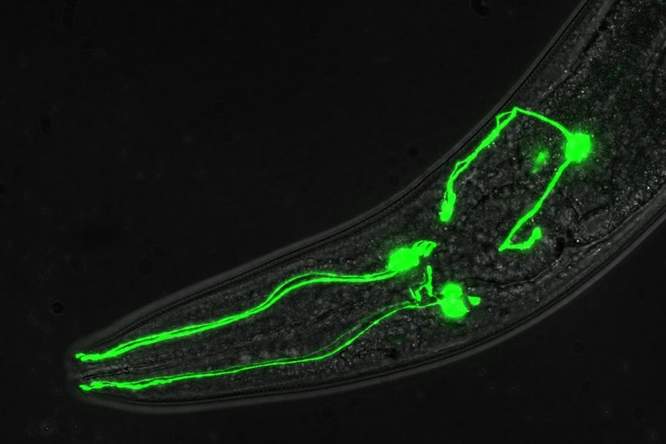

Amerikaanse neurowetenschappers hebben dit euvel nu handig weten te omzeilen. Door te focussen op de hersenactiviteit verbonden met de bewegingen van ons spraakorgaan (strottenhoofd, kaken, lippen en tong) konden ze een ‘decoder’ bouwen die ‘gedachte’ woorden en zinnen omzet in vrij goed verstaanbare tekst.

De onderzoekers ontwikkelden de decoder door vijf vrijwilligers honderden zinnen te laten uitspreken, zowel met klank, als zonder (enkel mimiek). Uit de opgemeten hersenactiviteit konden ze genoeg data halen om een relatief betrouwbare spraakcomputer te programmeren.

Het vakblad Nature, waarin het onderzoek is verschenen, heeft het over een grote doorbraak in het onderzoek naar brein-computerinterfaces. Al schrijft het er meteen bij dat het om een eerste prototype gaat, en dat een volwaardige decoder nog niet voor morgen is.