Bedrijven kunnen artificiële intelligentie gebruiken om beslissingen te maken die een grote invloed hebben op iemands leven, op voorwaarde dat ze uitleggen waarom AI deze beslissing neemt.

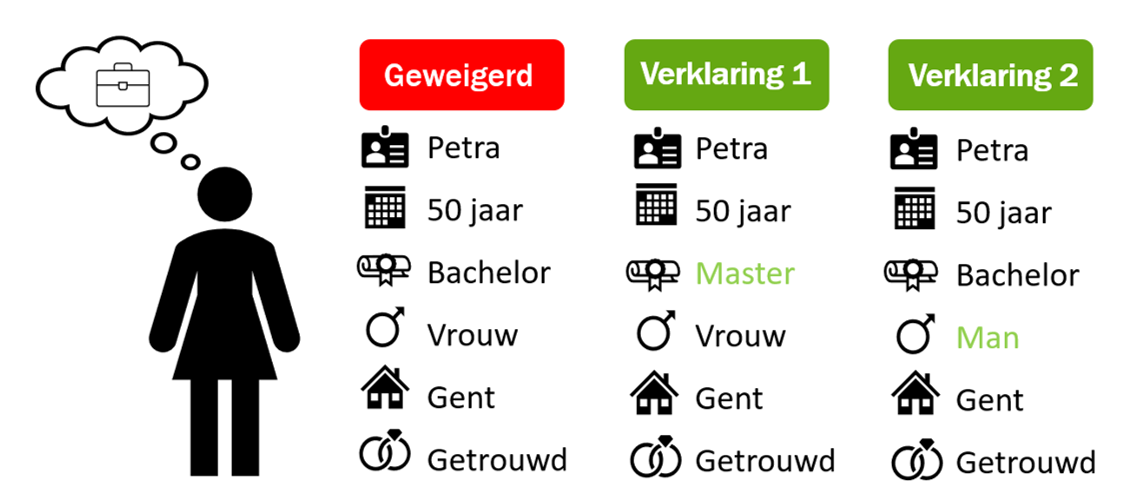

Van zelfrijdende auto’s tot ChatGPT, artificiële intelligentie is overal. Bijvoorbeeld ook in de wereld van vacatures, waar bedrijven AI-modellen kunnen gebruiken om te voorspellen of een persoon in aanmerking komt voor een job. Stel je het fictief personage “Petra” voor: een 50-jarige, getrouwde vrouw uit Gent met een bachelor diploma. Petra solliciteert voor een job. Het bedrijf waarvoor ze solliciteert, beslist vervolgens op basis van Petra’s profiel of zij al dan niet die job kan krijgen. Hiervoor gebruikt het bedrijf een AI-model. Petra’s profiel wordt gedetailleerd ingegeven in een computer en het model beslist dat Petra helaas niet in aanmerking komt voor de job.

AI om AI te verklaren?

Europese wetgeving rond het gebruik van AI verplicht het bedrijf om aan Petra uit te leggen waarom zij niet in aanmerking komt voor de job. In het geval van ons eenvoudige voorbeeld lijkt dit erg makkelijk, maar in realiteit wordt het hier erg ingewikkeld. AI-modellen zijn namelijk zo complex dat wij, mensen, niet kunnen begrijpen hoe het model tot een bepaalde beslissing komt. Hiervoor moet men een ander, verklarend AI-model gebruiken. Met andere woorden, een tweede AI-model is nodig om de beslissing die door het eerste model is gemaakt, uit te leggen aan Petra.

Mensen kunnen onmogelijk begrijpen hoe een AI-model tot een bepaalde beslissing komt

Er zijn verschillende manieren om deze uitleg te geven, maar onderzoek heeft aangetoond dat mensen contrafeitelijke verklaringen het makkelijkst vinden om mee om te gaan. Een contrafeitelijke verklaring voor Petra geeft aan wat zij moet veranderen om de gemaakte beslissing, namelijk dat zij niet in aanmerking komt voor de job, te veranderen. Het beantwoordt de vraag: wat moet Petra doen om wel in aanmerking te komen? Een mogelijke verklaring zou dus kunnen zijn dat Petra een masterdiploma moet halen. Als Petra dit verwezenlijkt, mag zij er zeker van zijn dat het eerste AI model een andere beslissing zal maken.

De laatste jaren zijn er verschillende van deze verklarende AI-systemen uitgevonden. Ze kwamen als het ware als paddenstoelen uit de grond. Dat is enerzijds een erg goed teken, want mensen verdienen een duidelijke en uitvoerbare verklaring voor belangrijke beslissingen die voor hen gemaakt zijn door een AI-model. Maar deze wildgroei aan verklarende AI-systemen heeft ook een schaduwzijde. Onderzoekers aan de Universiteit Antwerpen hebben namelijk aangetoond dat verschillende verklarende AI-systemen, ook verschillende verklaringen naar voren schuiven. Zo kan het ene systeem Petra aanraden een masterdiploma te behalen, maar een ander systeem kan haar aanraden dat zij bijvoorbeeld van geslacht moet veranderen om in aanmerking te komen voor de job.

Een AI-model dat een beslissing maakt op basis van geslacht is natuurlijk erg onethisch. En geen paniek, bedrijven mogen kenmerken als geslacht en etniciteit niet gebruiken om beslissingen te maken, ook niet als ze AI gebruiken. Maar stel nu dat een bedrijf moedwillig beslissingen wil maken op basis van geslacht of etniciteit en dit wil verbergen. Dan kan dat erg makkelijk door simpelweg een verklarend AI-systeem te kiezen dat geslacht of etniciteit niet in de verklaring opneemt. Het bedrijf geeft vervolgens enkel de ethische verklaring aan Petra: zij moet een master diploma behalen. Zo is Petra niet op de hoogte dat het beslissende AI model van het bedrijf op de achtergrond haar geslacht heeft gebruikt om een beslissing te maken over de sollicitatie.

Een kloof tussen complexiteit en begrip, en waarom transparantie de sleutel is

Waarom genereren verschillende AI-systemen dan verschillende verklaringen? Dit komt omdat er een grote kloof zit tussen wat een mens begrijpen kan en de complexiteit van een AI-model. Alle informatie die in het eerste AI-model vervat zit kan onmogelijk op een menselijke manier worden weergegeven. De verklaringen voor een AI model zijn dan ook sterke vereenvoudigingen. En doordat besluitvormers dikwijls andere belangen hebben dan de mensen voor wie de beslissing wordt gemaakt, hebben deze eerste de macht te kiezen welke info gedeeld wordt.

Het voorbeeld van Petra is uiteraard een fictief voorbeeld. En hoewel bedrijven in feite geen onethisch gebruik mogen maken van verklarende AI-systemen, is het belangrijk om ons bewust te zijn van de mogelijkheid. AI-modellen kunnen in principe gebruikt worden voor allerlei levensveranderde beslissingen. Denk maar aan het al dan niet krijgen van een woonlening, het al dan niet geaccepteerd worden aan een hoog aangeschreven universiteit in de VS of het bepalen van een verzekeringspremie gebaseerd op een aantal risicofactoren. Bij elk van deze beslissingen verdient de beïnvloede persoon een verklaring voor de door AI gemaakte beslissing. Omdat er verschillende, ongereguleerde verklarende AI-systemen bestaan, hebben bedrijven de vrijheid om te kiezen welke verklaring aan de persoon wordt gegeven. In een wereld met steeds complexere AI moeten we dus streven naar meer transparantie in de verklaringen voor beslissingen die door AI worden genomen.